© iStock.com/Widewingsstudio

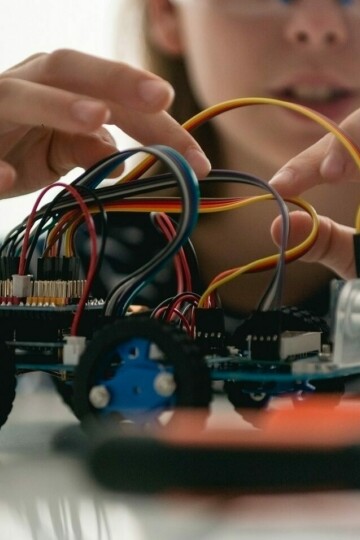

Künstliche Intelligenz

Die Entscheidungswege von Künstlicher Intelligenz (KI) sind bisher so

undurchsichtig, dass die Sicherheit von KI nicht ohne

weiteres bewertet werden kann. Künstliche Intelligenz muss allerdings für den Menschen nachvollziehbar sein, denn nur dann ist sie sicher genug, um in sicherheitskritischen Systemen wie dem autonomen Fahren zum Einsatz zu kommen.

Deswegen forscht das Fraunhofer IKS daran, wie Künstliche Intelligenz abgesichert werden kann. Eines unserer Forschungsziele ist es, neuronale Netze nachvollziehbar zu konzipieren und Unsicherheiten zu quantifizieren. Unsere

Softwarearchitektur erweitert KI-basierte Systeme und prüft die Entscheidungen auf Plausibilität. Um die KI nicht zu sehr einzuengen,

werden anstelle klassischer Safety-Ansätze, dynamische Verfahren

eingesetzt.

Lesen Sie mehr zur Absicherung von Künstlicher Intelligenz auf unserer Website: Künstliche Intelligenz

Artikel

Zum Thema Künstliche Intelligenz