Nächster Artikel

Machine Learning

Sicheres Reinforcement Learning

Reinforcement Learning (RL), zu deutsch bestärkendes oder verstärkendes Lernen, beschreibt eines der drei Hauptparadigmen von maschinellem Lernen (ML). Im Gegensatz zu den beiden anderen Methoden, Supervised Learning und Unsupervised Learning, erfolgt bei Reinforcement Learning das Lernen durch direkte Interaktion mit der Umgebung. Nachstehend folgt eine kurze Einführung.

© iStock.com/nedomacki

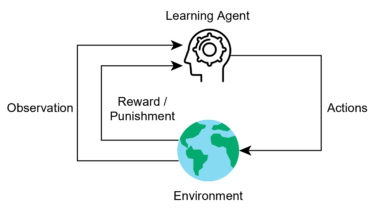

Beim Reinforcement Learning (RL) Framework beobachtet ein Agent die Umgebung und wählt eine Aktion, die er nach der Beobachtung der gegebenen Situation für angemessen hält. Die Umgebung schickt dann ein Feedbacksignal, das als Belohnung dient und diese Aktion mit einem Wert versieht. Durch die Belohnung erkennt der Agent, ob die Entscheidung gut war und es sich lohnt, sie in ähnlichen Situationen zu wiederholen, oder ob es eine schlechte Entscheidung mit einem unerwünschten Ergebnis war, die es zu vermeiden gilt.

© Fraunhofer IKS

Die Komponenten eines Reinforcement Learning Framework

Nehmen wir zum Beispiel eine Maus, die versucht, am entfernten Ende eines Labyrinths ein Stück Käse zu finden. Als RL-Problem betrachtet entspricht die Beobachtung dem, was die Maus sieht, die Aktion ist die Entscheidung, welche Richtung sie einschlagen soll, und die Belohnung ist der Snack am Ende des Labyrinths.

Dieses Konzept ist nicht wirklich neu, aber in den letzten Jahren hat es frischen Wind bekommen, da es zur Lösung von Problemen beitragen kann, wenn es zu viele denkbare Zustände gibt, um tatsächlich jede Möglichkeit zu berechnen. Daraus resultieren Szenarien wie zum Beispiel die Künstliche Intelligenz (KI), die ein Atari-Spiel spielt. Für weitere Schlagzeilen sorgte eine künstliche Intelligenz, die Professionelle im Go-Spiel besiegte [1].

Wie lässt sich Reinforcement Learning absichern

Obwohl RL bei komplexen Applikationen gute Ergebnisse erbringt, ist es definitiv nicht die Methode der Wahl für sicherheitskritische Anwendungen. Zum einen muss die KI die gelernte Regel sicher anwenden, was nur schwer für jede Situation garantiert werden kann. Zum anderen muss der Agent unbekannte Zustände erkunden, um von einer Umgebung zu lernen. Die üblichen explorativen Strategien beruhen dabei darauf, dass der Agent gelegentlich zufällige Aktionen wählt. Das ist eine einfache und effektive Methode, den Agenten zu zwingen, neue Situationen zu erleben und dabei eine Regel zu verfolgen, selbst wenn diese in der gegebenen Situation eindeutig unsicher ist. Beim Lernen in echten sicherheitskritischen Systemen müsste also ein explorativer Algorithmus die Sicherheit gewährleisten, weshalb diese Art Lernerlebnis sich überwiegend auf kontrollierte Szenarien und Simulationssoftware beschränkt.

In diesem Zusammenhang wurden sichere RL-Methoden vorgeschlagen, um diese Lücke zu überbrücken. Sie beinhalten Algorithmen, die verschiedene Sicherheitsaspekte in der Berechnung berücksichtigen. Es gibt zwei Kategorien von sicheren RL-Methoden: Safe Optimization und Safe Exploration [2].

Algorithmen für Safe Optimization integrieren die Sicherheitsaspekte in die eigentliche Regel. Die Optimierungskriterien können Beschränkungen beinhalten, die gewährleisten, dass Regelparameter immer innerhalb eines definierten sicheren Bereichs bleiben. Diese Algorithmen können ein gewisses Maß an Risiko berücksichtigen, wobei Risiko normalerweise als die Wahrscheinlichkeit definiert wird, unsichere Situationen zu erleben. Hier ist Folgendes zu beachten: Diese Methoden forcieren während des Trainings nicht unbedingt Sicherheit und gehen oft davon aus, dass der Agent unsichere Zustände einnehmen wird, bevor er eine sichere Regel gelernt hat.

Bei Safe Exploration geht es darum, den explorativen Prozess so zu ändern, dass der Agent davon abgehalten wird, unsichere Aktionen während des Trainings zu wählen. Eine Möglichkeit hierfür ist es, auf externes Wissen zuzugreifen, um den Agenten während seiner Erkundung zu leiten. Das könnte zum Beispiel ein Briefing am Anfang sein, das unsichere Bereiche definiert, die die KI während der Erkundung nicht betreten darf. Oder es könnte eine menschliche Lehrperson oder andere Entscheidungstragende sein, die den Agent bei der Erkundung anweisen.

Eine andere Methode zur sicheren Erkundung der Umgebung ist es, Risiko als Metrik einzusetzen. Diese Risikometrik schränkt den Agenten im Gegensatz zum oben beschriebenen risikozentrierten Optimierungsansatz nicht ein. Stattdessen dient sie als Anleitung für den Agenten, um riskante Situationen beim Lernen zu vermeiden.

Was ist Deep Reinforcement Learning?

Eine gängige Lösung für die Komplikationen beim Umgang mit sehr vielen Zuständen ist es, einen Funktionsapproximator in den Agenten einzubinden. Dieser Workaround ist zwingend, denn bei großen Problemen gibt es viele Aktionszustandspaare und es ist schlichtweg nicht möglich, dass ein Agent den Wert für jedes Paar lernt.

Beim Deep RL wird klassisches RL mit Deep Learning kombiniert. Deep neural networks (DNNs) dienen dazu, hochdimensionale Machine-Learning-Probleme zu lösen, wie sie in Computer-Vision-Anwendungen vorkommen. Ein DNN kann das auch für Deep-RL tun, wenn es als Funktionsapproximator zur Extraktion von Merkmalen verwendet wird, und lernen, Agenten für Probleme dieser Größe zu steuern.

Diese Kombination von DNN und RL ist für mehr Anwendungsfälle geeignet, aber es gelten hier die gleichen Vorbehalte, mit denen die Machine-Learning-Community auch schon bei der Verwendung von Deep Models in sicherheitskritischen Anwendungen zu kämpfen hatte. Machine-Learning-Systeme sind anfällig gegenüber feindlichen Angriffen, und RL-Regeln können in ähnlicher Weise gehackt werden [4]. Agenten müssen daher intrinsisch robust gegenüber feindlichen Angriffen sein.

Aber die Robustheit der Agenten ist nicht der einzige Stolperstein. Die Abschätzung und Erklärbarkeit

von Unsicherheiten muss ebenfalls verbessert werden, bevor RL-Modelle allgemein als sichere Entscheidungsalternativen akzeptiert werden können [5], [6].

Auf dem Weg zu intelligenten Entscheidungsagenten

Die RL-Forschungsgemeinschaft arbeitet daran, diese Probleme zu lösen und die oben beschriebenen Beschränkungen zu überwinden. Der Tag rückt immer näher, an dem sichere RL-Methoden zu intelligenten Entscheidungsagenten führen, die komplexe Aufgaben in realen Anwendungen lösen und dabei nur Aktionen wählen, die keinen Schaden anrichten.

Safe RL ist ein Schwerpunkt der Forschung am Fraunhofer-Institut für Kognitive Systeme IKS. Eines unserer Ziele ist die Entwicklung von Agenten, die Unsicherheiten erkennen und in der Lage sind, auch in unsicheren Umgebungen akkurate Einschätzungen abzugeben und angemessene Entscheidungen zu treffen. Gleichzeitig wollen wir Lernmodelle erstellen, die das Gelernte verallgemeinern und dadurch auch in Umgebungen außerhalb der Lernszenarien sicher agieren können. Damit soll Sicherheit auch dann gewährleistet sein, wenn der Agent Entscheidungen in unbekannten Situationen treffen muss.

[1] https://www.theguardian.com/te...

[2] Garcıa, Javier, and Fernando Fernández. "A comprehensive survey on safe reinforcement learning." Journal of Machine Learning Research 16.1 (2015): 1437-1480.

[3] Alshiekh, Mohammed, et al. "Safe reinforcement learning via shielding." Proceedings of the AAAI Conference on Artificial Intelligence. Vol. 32. No. 1. 2018.

[4] Gleave, Adam, et al. "Adversarial policies: Attacking deep reinforcement learning." arXiv preprint arXiv:1905.10615 (2019).

[5] Clements, William R., et al. "Estimating risk and uncertainty in deep reinforcement learning." arXiv preprint arXiv:1905.09638 (2019).

[6] Fischer, Marc, et al. "Online robustness training for deep reinforcement learning." arXiv preprint arXiv:1911.00887 (2019).

Dieses Vorhaben wurde im Rahmen des Projekts Unterstützung des thematischen Aufbaus des Instituts für Kognitive Systeme durch das Bayerische Staatsministerium für Wirtschaft, Landesentwicklung und Energie gefördert.