Nächster Artikel

Unsicherheit in autonomen Systemen, Teil 2

Wo sich Fehler einschleichen können

Nicht behandelte Unsicherheiten in autonomen Systemen beeinträchtigen deren Funktionsfähigkeit und können zu einem Sicherheitsrisiko werden. In Teil 1 der Reihe zum Thema Unsicherheit stand ein Klassifizierungssystem für Unsicherheit im Mittelpunkt. In Teil 2 präsentieren wir konkrete Quellen der Unsicherheit, wie sie in der wissenschaftlichen Literatur diskutiert werden.

© iStock/Wicki58

Ein wichtiger Schritt in der Entwicklung eines autonomen Systems ist es, sämtliche Unsicherheiten, welche die Entscheidungsfähigkeit des Systems beeinträchtigen, zu identifizieren. Das Klassifizierungssystem aus Teil 1 dieser Reihe hilft dabei, denn es enthält viele Aspekte, die sonst leicht zu übersehen sind.

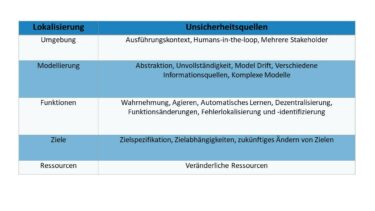

Zusätzlich zu Taxonomien für Unsicherheit haben sich Forscherinnen und Forscher auch umfassend mit konkreten Quellen der Unsicherheit auseinandergesetzt. Diese Arbeiten liefern ein noch tieferes Verständnis darüber, wie Unsicherheit die Funktionalität von autonomen Systemen beeinträchtigt. Tabelle 1 zeigt eine Sammlung von Unsicherheitsquellen, gruppiert nach ihrer Lokalisierung im System. Im Folgenden erläutern wir sie genauer.

© Fraunhofer IKS

Tabelle 1: Quellen der Unsicherheit, gruppiert nach Lokalisierung im System

Umgebung

Bei Unsicherheit in der Umgebung geht es nicht darum, wie das System seine Umwelt wahrnimmt, sondern wie vollständig der Entwickler des Systems die Einsatzumgebung kennt. Für viele komplexe Systeme ist der Ausführungskontext selbst zu variantenreich, um ihn vollständig zu beschreiben. Eine besondere Rolle spielt dabei das unvorhersagbare Verhalten von Menschen, wenn das System mit Humans-in-the-loop arbeiten wird. Eine weitere Quelle für Unsicherheit in der Umgebung ist ein sehr heterogener Kontext, der durch mehrere Stakeholder definiert wird. Solch eine Situation entsteht beispielsweise, wenn Roboter von verschiedenen Herstellern zusammenarbeiten müssen, um eine Aufgabe zu erledigen.

Modellierung

Modelle sind essenziell, damit autonome Systeme ihre Aufgaben erfüllen können, da die Vorgänge der echten Welt für eine detaillierte Verarbeitung häufig zu komplex sind. Eine Darstellung als Modell erlaubt es technischen Systemen, trotzdem Entscheidungen zu treffen. Diese absichtliche Abstraktion von Details birgt jedoch eine Quelle für Unsicherheit, da sich das Modell nicht exakt so wie die echte Welt verhalten wird. Wenn ein Prozess nicht ausreichend verstanden wurde, kann so auch ein unvollständiges

Modell entstehen, in dem wichtige Details fehlen. Ein weiteres Problem ergibt sich aus dem Lebenszyklus des Systems: Wenn das Modell nicht regelmäßig aktualisiert wird, kann Model Drift dazu führen, dass es die realen Gegebenheiten nicht mehr präzise darstellt. Auch kann es schwierig sein, Modelle mit verschiedenen Informationsquellen in Einklang zu bringen, wie zum Beispiel diskrete und kontinuierliche Modelle, die in der Softwareentwicklung verwendet werden. Zuletzt kann all dies zu komplexen Modellen führen, die schwer zu verstehen und zu verifizieren sind.

Funktionen

Die Funktionen des autonomen Systems können von vielen Unsicherheitsquellen betroffen sein. Sowohl Funktionen der Wahrnehmung als auch des Agierens können unsichere Auswirkungen und Nebeneffekte haben, besonders wenn sie auf automatischem Lernen basieren. In dezentralen Architekturen, in denen mehrere Komponenten zusammen eine Funktion erbringen, besteht ebenfalls eine Gefahr für emergentes Verhalten. Auch durch Funktionsänderungen in Folge von Softwareupdates können neue Unsicherheiten ins System eingebracht werden. Abschließend wirken sich zudem Hardware- und Softwarefehler auf die Entscheidungsfähigkeit des Systems aus. Die zeitnahe Lokalisierung und Identifikation von Fehlern verschafft mehr Sicherheit darüber, wozu das System derzeit in der Lage ist.

Ziele

Autonome System zeichnen sich dadurch aus, dass sie selbstständig im Voraus definierte Ziele verfolgen. Damit sich das System so verhält, wie erwartet, muss die Spezifikation der Ziele korrekt und genau formalisiert sein. Weitere Quellen der Unsicherheit liegen in den Wechselwirkungen zwischen mehreren Zielen: Nicht erkannte Abhängigkeiten zwischen Zielen kann die Priorisierung der Ziele unerwartet beeinflussen, genauso wie das zukünftige Ändern von Zielen, wenn diese nicht mehr aktuell sind.

Ressourcen

Genauso wie die Ziele sind auch die verfügbaren Ressourcen eines autonomen Systems veränderlich. Wenn sich die Verfügbarkeit oder die Auslastung einzelner Ressourcen, wie zum Beispiel der Rechenkapazität, ändert, hat das einen Einfluss auf die Servicequalität des Systems. Dies betrifft vor allem komplexe Systeme, die nicht echtzeitfähig getaktet werden können.

Das Thema Unsicherheit ist in den letzten Jahren stark in den Fokus der Forschung gerückt. Auch in der praktischen Anwendung begegnen Industriepartner dem Thema immer häufiger. Oft handelt es sich dabei um Unsicherheiten, die die Funktionen des Systems betreffen. Besonders die Unsicherheitsquelle Wahrnehmung hat große Auswirkungen auf das System. Aber wie in beiden Teilen der Reihe beschrieben, sind auch andere Aspekte der Unsicherheit wichtig. Das Fraunhofer-Institut für Kognitive Systeme IKS forscht an einem umfassenden Unsicherheitsmanagement, das alle Faktoren der Unsicherheit unter die Lupe nimmt.