Nächster Artikel

Künstliche Intelligenz

Warum Sicherheit wichtig ist

Maschinelles Lernen stellt eine enorme Herausforderung in punkto Sicherheit (Safety) dar. Ohne ein tragfähiges Konzept zur Absicherung kommen viele hervorragende Ideen erst gar nicht auf den Markt. Es ist daher nicht überraschend, dass KI-Sicherheit in den letzten Monaten viel mehr Aufmerksamkeit gewidmet wird. In einer kurzen Artikelreihe legen wir daher das Augenmerk auf die Bedeutung der Sicherheit für Künstliche Intelligenz. Der erste Artikel konzentriert sich dabei auf etwas ganz Grundsätzliches: Was bedeutet Sicherheit eigentlich? Ein Punkt ist hier ganz wichtig: sichere KI hat weniger mit KI selbst als vielmehr mit Safety Engineering zu tun.

© iStock.com/gustavofrazao

Für Sicherheitsexpertinnen und -experten ist klar, dass maschinelles Lernen eine enorme Herausforderung für die Sicherheit (Safety) darstellt. Kurz gesagt: Ein Konzept wie sicheres maschinelles Lernen ist derzeit technisch nicht realisierbar. Wir können lediglich versuchen, die Sicherheit auf Systemebene zu gewährleisten, d. h. die Sicherheit eines Kognitiven Systems trotz des Einsatzes von nicht sicherem maschinellem Lernen für sicherheitskritische Funktionen sicherzustellen. Aus diesem Grund handelt es sich eher um eine Herausforderung des Safety Engineerings als um eine KI-Herausforderung.

In einer Zeit, in der sichere KI an Attraktivität gewinnt, begegne ich in Gesprächen oft einem erschreckend mangelhaften Verständnis dessen, was Sicherheit eigentlich bedeutet. Manchmal fehlt sogar völlig das Verständnis dafür, warum Sicherheit überhaupt ein Thema sein sollte.

Obwohl KI-Sicherheit enorm wichtig ist und größte Herausforderungen an ihre Absicherung stellt, fragen mich viele (einschließlich Managern, Politikern und KI-Experten), warum wir das Ganze überhaupt so groß thematisieren. Sie sind überrascht, dass das Thema Sicherheit noch als Problem gilt, wenn sie andererseits lesen, dass Hightech-Unternehmen autonome Fahrzeuge herstellen, die bereits Millionen von Kilometern zurückgelegt haben.

Die Tatsache, dass eine Reihe von Rückschlägen bereits zu Personenschäden und Todesfällen geführt hat, scheint von vielen einfach hingenommen zu werden – ein erschreckender Gedanke. Die Gefährdung der Gesundheit und des Lebens von Menschen kann niemals ein annehmbarer Preis für den technischen Fortschritt sein. Dies gilt umso mehr, als die Nutzer von KI und autonomen Systemen kaum in der Lage sind, das Risiko zu verstehen, dem sie sich aussetzen. Noch wichtiger ist, dass wir das Risiko von Kollateralschäden berücksichtigen müssen. Durch autonome Fahrzeuge werden beispielsweise auch andere Verkehrsteilnehmer, insbesondere ungeschützte Verkehrsteilnehmer wie Radfahrer oder Fußgänger, inakzeptablen Risiken ausgesetzt – ohne dass sie eine Wahl haben.

Andererseits bin ich auch davon überzeugt, dass die Antwort nicht darin besteht, KI-basierten Systemen die Schuld zuzuschieben oder gar deren Einsatz in sicherheitskritischen Anwendungen zu verbieten. Im globalen Wettbewerb wird Künstliche Intelligenz zwangsläufig auf die eine oder andere Art ihren Weg in sicherheitskritische Anwendungen finden. Daher sollte unser vorrangiges Ziel darin bestehen, zunächst einen sicheren und dennoch wirtschaftlich rentablen Ansatz zu finden.

Sicherheit verstehen bedeutet Risiken zu verstehen

Um besser zu verstehen, wovon wir sprechen, sollten wir zunächst betrachten, was Sicherheit im Sinne von Safety eigentlich bedeutet. Sicherheit (Safety) ist nichts anderes als die Freiheit von unvertretbaren Risiken. Das Risiko wiederum messen wir als Kombination aus der Eintrittswahrscheinlichkeit eines Schadens und der Schwere dieses Schadens. Das vertretbare Risiko ist eine von der Gesellschaft implizit definierte Schwelle. Mit Normen und Gesetzen wird versucht, dieser gesellschaftlichen Schwelle Rechnung zu tragen und explizite Maßnahmen abzuleiten, die sicherstellen, dass das Restrisiko von Systemen, die auf den Markt gebracht werden, geringer ist als das vertretbare Risiko.

© Fraunhofer IKS

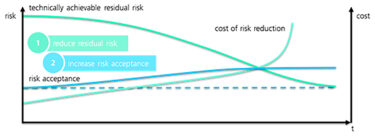

Abbildung 1: Das Verhältnis zwischen Restrisiko, akzeptablem Risiko und Kosten

Allgemein ausgedrückt führt dies zu zwei grundlegenden Möglichkeiten, wie versucht werden könnte, Sicherheit zu erreichen – wie in Abbildung 1 dargestellt. Normalerweise sollte das Ziel darin bestehen, das Restrisiko auf ein vertretbares Niveau zu senken. Dem steht der Effekt gegenüber, dass die Kosten oft exponentiell ansteigen, je stärker das Risiko gemindert werden soll. Es überrascht daher nicht, dass der Versuch, das vertretbare Risiko zu erhöhen, eine verlockende Alternative darstellt. Betrachtet man die rapide steigende Zahl von Hochglanz-Marketingmaterialien mit Titeln wie »Safety Case« in Verbindung mit Marketingkampagnen, so scheinen einige Unternehmen eine gefährliche Gratwanderung zwischen vernünftiger Aufklärung und absichtlicher Manipulation zu vollziehen. Was auch immer wir davon halten mögen – es ist Teil des Spiels.

Tatsächlich ist der Maßstab für die Risikoakzeptanz jedoch mehr oder weniger eindeutig. Ohne ins Detail zu gehen: Es ist ein intuitiver und unbestrittener Grundsatz, dass die Einführung neuer Technologie das Risiko nicht erhöhen darf. Selbstfahrende Autos müssen die Gefahr im Verkehr nachweislich im Vergleich zu heute reduzieren, und zwar für jeden Verkehrsteilnehmer. KI-basierte medizinische Geräte müssen zu weniger Schäden führen als die heute verfügbaren Geräte, und KI-basierte Maschinen in der Produktion dürfen das Risiko für die Mitarbeitenden, die sie verwenden, nicht erhöhen. Und wenn man die Diskussion über die Abwägung von durch Kognitive Systeme verursachten Todesfällen gegen die Zahl der potenziell geretteten Leben wirklich eröffnen will, ist dies nur dann akzeptabel, wenn die Zahl der nachweislich geretteten Leben die der Todesfälle um mehrere Größenordnungen übersteigt (sofern dies überhaupt der Fall ist).

In den letzten Monaten ist es noch wichtiger geworden, an diesen Maßstab zu erinnern. Es gibt zahlreiche gute und nützliche Initiativen, die sich mit »zertifizierbarer KI« befassen und von der KI-Gemeinschaft initiiert wurden. Sie berücksichtigen viel mehr als nur die Sicherheit, einschließlich sehr wichtiger Aspekte wie Diskriminierungsfreiheit, Vertraulichkeit usw., aber sie gehen auch auf das Thema Sicherheit ein. Ich unterstütze diese Initiativen voll und ganz. Dennoch ist es äußerst wichtig, dass dieser Trend nicht zu einer Verwässerung der Sicherheitsmaßstäbe führt. So gut ich auch die technische Herausforderung verstehe, die Genauigkeit von Algorithmen des maschinellen Lernens zu garantieren, so besteht doch noch immer eine riesige Lücke zwischen ausgezeichneter Qualität aus der KI-Perspektive und dem, was wir tatsächlich als sicher betrachten können. Jeder Versuch, durch eine Neudefinition von Sicherheit die Oberhand bei der Interpretation dessen zu gewinnen, was sichere KI bedeutet, ist wenig hilfreich. Selbst wenn wir eine flexible Auslegung des Grundsatzes, dass neue Technologien das Risiko für die Nutzer nicht erhöhen dürfen, akzeptieren würden, kann eine Sicherheit, die fünf bis acht Größenordnungen schlechter ist als heute, keine Option sein. Wir dürfen den Maßstab für die Rettung von Menschenleben nicht auf der Basis der technischen Machbarkeit definieren.

Sicherheitstechnik ist der Schlüssel

Die Erhöhung des Risikoakzeptanzniveaus ist offensichtlich kein vernünftiger Weg, Sicherheit zu erreichen. Das Verbot von maschinellem Lernen für sicherheitskritische Systeme kommt ebenfalls nicht in Betracht. Daher benötigen wir neue Lösungen für die Absicherung von Künstlicher Intelligenz. Während die KI-Forschung bis zu einem gewissen Grad helfen kann, indem sie das maschinelle Lernen robuster und besser erklärbar macht, liegt die eigentliche Herausforderung im Safety Engineering.

Mittlerweile sollten wir erkannt haben, dass es mit traditionellen Ansätzen zur Absicherung bereits schwierig ist, die Sicherheit von konventionellen komplexen Softwaresystemen zu garantieren. Funktionen, die auf der Basis von neuen, bahnbrechenden Paradigmen entwickelt werden, können einfach nicht mit denselben alten konservativen Sicherheitskonzepten abgesichert werden. Tatsächlich müssen wir Sicherheit als Konzept überdenken und den Mut haben, neue Wege zur Absicherung zu beschreiten. Wir brauchen so etwas wie die Next-Generation Safety, auf die wir in den kommenden Artikeln näher eingehen werden.

Den Stier bei den Hörnern packen

Sicherheit und Absicherung beruhen auf einem allgemein anerkannten Wissensstand. Das Gleiche gilt für Sicherheitsnormen, die den allgemein anerkannten Stand der Technik widerspiegeln. Für das maschinelle Lernen gibt es jedoch keine allgemein anerkannten Sicherheitskonzepte. In der Regel dauert der Aufbau einer solchen Basis für die Gewährleistung von Sicherheit und entsprechende Normen Jahrzehnte. Jedoch sollten wir offensichtlich von einer Option absehen, die den Sicherheitsmaßstab herabsetzt. Wir können auch nicht mehrere Jahre warten – das gilt umso mehr, weil wir das notwendige Wissen nicht erlangen werden, wenn wir keine Systeme im Einsatz haben, von denen wir lernen können.

Vielmehr sollten wir den Stier bei den Hörnern packen. Wir sollten nicht versuchen, allgemeine Standards für sichere KI zu definieren. Momentan haben wir einfach keine geeigneten Lösungen, und die Festlegung von Standards auf der Grundlage bestmöglicher Schätzungen ist nicht empfehlenswert. Anstelle von allgemeinen Lösungen sollten wir versuchen, einzelne Systeme durch äußerst spezifische, auf das jeweilige System zugeschnittene Lösungen abzusichern. Dies ist natürlich mit erheblichem Aufwand verbunden, da wir einen kompletten individuellen Safety Case durcharbeiten müssen – von allgemeinen Sicherheitszielen bis hin zu sehr spezifischen Nachweisen, die oft nur mit viel Aufwand erbracht werden können.

Darüber hinaus müssen wir ein solides und systematisches Überwachungssystem etablieren, um sicherzustellen, dass wir Vorfälle in der Praxis erkennen und schnelle Iterationszyklen gewährleisten, um so das System, alle vergleichbaren Systeme und die Sicherheitsstandards zu verbessern, während wir Schritt für Schritt das erforderliche Wissen aufbauen. Das bedeutet zwar, dass die Systeme, die wir auf den Markt bringen können, vielen Einschränkungen unterliegen werden, wir können diese jedoch im Laufe der Zeit schrittweise lockern. Sicherheitsstandards für KI sollten sich daher darauf konzentrieren, die (rechtliche) Grundlage für einzelne Safety Cases zu schaffen, begleitet von einer iterativen Verbesserung der Produkte und Standards im Laufe der Zeit.

Weder wirtschaftliche Gründe noch eine KI-orientierte Neudefinition von Sicherheit auf der Basis der technischen Machbarkeit sollten den Fortschritt bei sicherer KI vorantreiben. Stattdessen ist es die Aufgabe der Sicherheitsingenieure, Sicherheit in Richtung Next-Generation Safety, also auf die zukünftige Absicherung zu überdenken und Standards und entsprechende Rahmenbedingungen zu etablieren, die eine frühzeitige Markteinführung einzelner Produkte auf der Basis ganz individueller Safety Cases ermöglichen. Und dabei schnell zu lernen, ohne Menschen zu gefährden.

Der erste Artikel dieser kurzen Reihe ist für die strategische Managementebene gedacht, während die folgenden Artikel das Thema auf einer eher technischen Ebene behandeln. Als nächstes: Warum die Gewährleistung der Sicherheit von KI/ML eine Herausforderung ist.

Anmeldung zum SAFE INTELLIGENCE Newsletter

Sie wollen immer auf dem aktuellsten Stand sein und regelmäßig Informationen zum Fraunhofer IKS erhalten? Dann melden Sie sich hier zu unserem Newsletter an: www.iks.fraunhofer.de/newsletter