Nächster Artikel

Konzept-basierte Modelle

Wie visuelle Konzepte helfen, die Entscheidung einer KI zu verstehen

Moderne KI-Modelle haben bei verschiedenen Computer-Vision-Aufgaben wie der Bildklassifizierung bemerkenswerte Fähigkeiten bewiesen. Ihr Entscheidungsprozess bleibt jedoch meist undurchsichtig (Black-Box-Problem). Dies kann insbesondere bei sicherheitskritischen Anwendungen wie der medizinischen Bildgebung oder dem autonomen Fahren problematisch sein. Das Fraunhofer IKS erforscht Wege, Transparenz in diese Black Box zu bringen.

© iStock/yul38885

Der Einsatz von Künstlicher Intelligenz (KI) in autonomen Fahrzeugen oder in der Medizintechnik erfordert in der Regel ein gewisses Maß an Interpretierbarkeit ihrer Entscheidungen. Neben der Erfüllung von Sicherheitsanforderungen, kann Interpretierbarkeit nämlich auch dazu beitragen, Unzulänglichkeiten des Modells während der Entwicklung und Anwendung aufzudecken und zu beheben. Ein Radiologe könnte beispielsweise die Erklärung einer KI-Entscheidung heranziehen, um deren Vertrauenswürdigkeit bei der Erstellung einer Diagnose zu beurteilen.

Die Entscheidungsprozesse moderner tiefer neuronaler Netze (Deep Neural Networks, DNNs) zu verstehen, kann aber eine Herausforderung sein. Ein gängiger Ansatz in der Computer Vision ist die Erstellung von Saliency Maps, die Regionen im Bild hervorheben, die für die Vorhersage relevant sind. Diese Erklärungsmethoden sind jedoch fehleranfällig und durch visuelle Begutachtung oft schwer zu interpretieren [1]. In den letzten Jahren hat man sich zunehmend bemüht, Modelle auf eine für den Menschen verständliche Weise zu erklären, indem man übergeordnete visuelle Konzepte verwendet (e.g. [2]–[5]).

Was sind visuelle Konzepte?

Konzepte werden als Merkmale in einem Bild definiert, die für die Klassifizierungsaufgabe relevant sind. Für die Klassifizierung von Verkehrsschildern könnten beispielsweise die Form eines Verkehrsschildes, seine Farbe oder Symbole als Konzepte definiert werden (siehe Abbildung 1).

© Fraunhofer IKS

Abb. 1: Beispiele von Konzeptannotationen für verschiedene Verkehrsschilder. (Die Bilder sind Teil des GTSRB-Data Sets [6].

Konzept-basierte Modelle zielen darauf ab, solche übergeordneten Konzepte in einem Eingabebild vorherzusagen und diese Konzepte zur Klassifizierung des Bildes zu verwenden. Concept Bottleneck Models [2], als Beispiel für diese Art von Modellen, bestehen aus einem Concept Model und einem Task Model. Das Concept Model, in der Regel ein Convolutional Neural Network (CNN), gibt Konzeptvorhersagen auf der Grundlage eines Eingabebildes aus. Das Task Model, z. B. ein einfaches neuronales Netz zur Klassifikation (Multi-Layer Perceptron, MLP), klassifiziert das Bild auf der Grundlage der Ergebnisse des Concept Models.

Bei der Klassifizierung von Verkehrsschildern wird das Concept Model darauf trainiert, Konzepte wie Form, Farbe oder Zahlen auf dem Schild zu erkennen. Das Task Model klassifiziert dann das Verkehrsschild auf der Grundlage der erkannten Konzepte (siehe Abbildung 2).

© Fraunhofer IKS

Abb. 2: Klassifizierungsprozess für Konzept-basierte Modelle.

Das Training des Concept Models erfordert Konzeptannotationen in Form von binären Labels, d.h. Konzept »vorhanden« oder »nicht vorhanden«, für jedes definierte Konzept und jedes Bild. Für komplexe Konzept-Klassen-Beziehungen kann das Task Model anhand von Daten trainiert werden. In einem einfacheren Fall kann es auch von einem Fachexperten mit Entscheidungsregeln ohne jegliches Training modelliert werden. Zum Beispiel könnte eine der Regeln lauten: »Wenn die Konzepte A, B und C vorhanden sind, sollte das Bild als X klassifiziert werden«.

Konzept-basierte Modelle bieten Vorteile

Konzept-basierte Modelle erhöhen die Interpretierbarkeit, indem sie den Entscheidungsprozess transparenter machen und dabei eine ähnliche Leistung erzielen wie Standardmodelle zur Bildklassifizierung [2]. Sie geben Aufschluss darüber, welche Konzepte im Bild erkannt werden und welche dieser Konzepte in welcher Kombination für die Klassenvorhersage relevant sind. Dieses Maß an Interpretierbarkeit kann dazu beitragen, Unzulänglichkeiten des Modells in seinem Entscheidungsprozess aufzudecken und Transparenz zu schaffen, im Einklang mit gängigen Sicherheitsrichtlinien (z. B. EU AI Act [7]).

Die Konzept-Zwischenebene bietet nicht nur Interpretierbarkeit, sondern ermöglicht auch Intervention während der Anwendung. Jede Änderung an den Konzeptvorhersagen beeinflusst auch die Klassenvorhersage. Auf diese Weise könnte ein Fachexperte potenziell falsche Konzeptvorhersagen für schwierige Bilder überprüfen, was wiederum eine Fehlklassifizierung im Task Model verhindern könnte.

Aktuelle Herausforderungen

Obwohl diese Vorteile vielversprechend sind, müssen noch einige Herausforderungen bewältigt werden, bevor wir Konzept-basierte Modelle in einem sicherheitskritischen Kontext einsetzen können.

Eine zentrale Herausforderung für Erklärungsmethoden ist die Evaluierung der Erklärung selbst, d. h. die Frage, wie überprüft werden kann, ob die Erklärung den Entscheidungsprozess des KI-Modells korrekt widergibt. Im Zusammenhang mit Konzept-basierten Modellen besteht die Schwierigkeit darin, den Nachweis zu erbringen, dass die Konzeptvorhersagen die zugehörigen Konzepte im Bild wirklich repräsentieren. Konzeptvorhersagen können mehr Informationen als nur das Auftreten des Konzepts enthalten oder auf anderen korrelierten Konzepten oder Merkmalen im Bild beruhen. Folglich sind alle Erklärungen, die sich auf diese fehlerhaften Konzeptvorhersagen stützen, nicht genau.

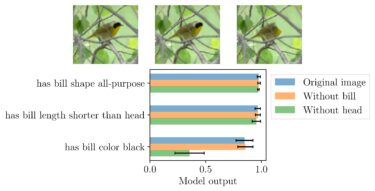

Abb. 3: Ergebnisse eines Concept Models für Bilder, in denen der Schnabel oder der ganze Kopf des Vogels entfernt wurde. [8]

Abbildung 3 veranschaulicht dieses Problem. Sie zeigt die Ergebnisse eines Modells, das auf Konzepten von Vögeln trainiert wurde, für drei verschiedene Bilder: das Originalbild und zwei manipulierte Bilder, eines ohne den Schnabel (bill) und eines ohne den Kopf des Vogels. Wir würden erwarten, dass sich die Vorhersage für Konzepte, die den Schnabel des Vogels beschreiben, von »vorhanden« auf »nicht vorhanden« ändert (Model Output < 0,5), wenn dieser Teil nicht mehr sichtbar ist. Wir sehen jedoch, dass diese Konzepte immer noch mit hoher Konfidenz vorhergesagt werden, obwohl der Schnabel oder sogar der ganze Kopf aus dem Bild entfernt wurde. Dieses Problem wird in der Regel nicht von klassischen Metriken, wie der Test Accuracy (Anteil korrekter Vorhersagen), erkannt, die auf Daten mit ähnlichen Eigenschaften wie die der Trainingsdaten berechnet werden. In letzter Zeit wurden jedoch zusätzliche Methoden zur Evaluierung von Konzeptmodellen vorgeschlagen, die zur Lösung dieses Evaluierungsproblems beitragen können (z. B. [8], [9]).

Der Blog-Beitrag bezieht sich auf das Paper »Concept Correlation and Its Effects on Concept-Based Models« von Lena Heidemann, Maureen Monnet, Karsten Roscher.

In der aktuellen Veröffentlichung »Concept Correlation and Its Effects on Concept-Based Models« [8] werden die Herausforderung von Konzeptkorrelationen für Konzept-basierte Modelle untersucht. Ein Concept Model kann Korrelationen im Datensatz ausnutzen, um bestimmte Konzepte nur auf der Grundlage des Auftretens der korrelierten Konzepte vorherzusagen, und dabei trotzdem eine hohe Test Accuracy erreichen. Dies kann in seltenen Szenarien, in denen die korrelierten Konzepte unabhängig voneinander auftreten, zu Fehlklassifikationen führen. Insbesondere in sicherheitskritischen Anwendungen, wie der medizinischen Bildgebung, sollte jede Konzeptvorhersage auf dem Vorhandensein des jeweiligen Konzepts im Bild basieren. Unsere Analyse zeigt, dass dieses Problem für viele Anwendungen von Konzeptmodellen besteht.

Darüber hinaus stellen wir einfache Lösungsansätze vor, wie z. B. Loss Weighting, die erste vielversprechende Ergebnisse zeigen. Eine detailliertere technische Beschreibung des Problems und möglicher Lösungen finden Sie in unserem Paper hier/[8]. In der Zwischenzeit arbeitet das zuständige Team am Fraunhofer IKS weiter daran, diese Herausforderungen zu bewältigen und Computer-Vision-Modelle besser interpretierbar zu machen.

[1] J. Adebayo, J. Gilmer, M. Muelly, I. Goodfellow, M. Hardt, and B. Kim, ‘Sanity Checks for Saliency Maps’, in Advances in Neural Information Processing Systems, 2018. Available: https://proceedings.neurips.cc...

[2] P. W. Koh et al., ‘Concept Bottleneck Models’, in Proceedings of the 37th International Conference on Machine Learning, 2020, pp. 5338–5348. Available: https://proceedings.mlr.press/...

[3] Z. Chen, Y. Bei, and C. Rudin, ‘Concept whitening for interpretable image recognition’, Nature Machine Intelligence, vol. 2, no. 12, Art. no. 12, 2020, doi: 10.1038/s42256-020-00265-z.

[4] M. Losch, M. Fritz, and B. Schiele, ‘Interpretability Beyond Classification Output: Semantic Bottleneck Networks’, arXiv:1907.10882, 2019, doi: 10.48550/arXiv.1907.10882.

[5] C. Li, M. Z. Zia, Q.-H. Tran, X. Yu, G. D. Hager, and M. Chandraker, ‘Deep Supervision with Intermediate Concepts’, IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 41, no. 8, pp. 1828–1843, 2019, doi: 10.1109/TPAMI.2018.2863285.

[6] J. Stallkamp, M. Schlipsing, J. Salmen, and C. Igel, ‘The German Traffic Sign Recognition Benchmark: A multi-class classification competition’, in The 2011 International Joint Conference on Neural Networks, 2011, pp. 1453–1460.

[7] European Commission, ‘Proposal for a regulation of the European Parliament and of the Council laying down harmonised rules on artificial intelligence (Artificial Intelligence Act) and amending certain Union legislative acts’, COM/2021/206 final, 2021.

[8] L. Heidemann, M. Monnet, and K. Roscher, ‘Concept Correlation and Its Effects on Concept-Based Models’, presented at the Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision, 2023, pp. 4780–4788. Available: https://openaccess.thecvf.com/...

[9] M. E. Zarlenga et al., ‘Towards Robust Metrics for Concept Representation Evaluation’, arXiv, arXiv:2301.10367, Jan. 2023. doi: 10.48550/arXiv.2301.10367.

Dieses Vorhaben wurde im Rahmen des Projekts Unterstützung desthematischen Aufbaus des Instituts für Kognitive Systeme durch das Bayerische Staatsministerium für Wirtschaft, Landesentwicklung undEnergie gefördert.