Nächster Artikel

Künstliche Intelligenz

Was passiert, wenn KI nicht richtig funktioniert?

Künstliche Intelligenz (KI) muss mit Unsicherheiten umgehen können, damit wir uns darauf verlassen können, dass sie auch in sicherheitskritischen Anwendungen funktioniert, zum Beispiel in autonomen Fahrzeugen. Das Fraunhofer-Institut für Kognitive Systeme IKS erforscht Möglichkeiten, wie KI logisch mit Unsicherheiten umgehen kann. Eine davon ist die Operational Design Domain.

© iStock.com/Oleh-Slobodeniuk

Die jüngsten Fortschritte beim Thema Künstliche Intelligenz sind beeindruckend. Eine KI kann zwischen einem Hotdog und einem Nicht-Hotdog unterscheiden. Eine andere spielt erfolgreich Schach gegen einen Schachgroßmeister. Und eine weitere löst das Rätsel um die Mechanismen der Proteinfaltung und revolutioniert damit die Medizin.

Angesichts dieser außergewöhnlichen Leistungen kann man uns kaum vorwerfen, dass wir hohe Erwartungen an KI-gesteuerte Systeme haben. Aber sind wir wirklich an dem Punkt angelangt, dass wir sorglos ein Nickerchen am Steuer halten können, während uns ein KI-gesteuertes Fahrzeug ans Ziel bringt? Diejenigen von uns, die ein selbstfahrendes Taxi in Stadtgebieten gesehen haben, würden wahrscheinlich Ja sagen.

Würde die Antwort aber gleich ausfallen, wenn dieses Taxi Haarnadelkurven auf einer kurvigen Bergstraße bei sintflutartigem Regen bewältigen müsste? Wahrscheinlich nicht. Zweifel an der Sicherheit von selbstfahrenden Fahrzeugen sind nicht von der Hand zu weisen – man bedenke nur den tödlichen Uber-Unfall, der für Schlagzeilen gesorgt hat. Solche Unfälle liegen überwiegend darin begründet, dass KI nicht in der Lage ist, bestimmte Situationen korrekt einzuschätzen, aber zum Teil liegen sie auch daran, dass wir Menschen die Fähigkeiten von KI deutlich überschätzen.

KI versagt bei bestimmten Aufgaben, die Menschen ganz mühelos ausführen. Und dafür gibt es Gründe.

Deep Neural Networks (DNN) sind ein Versuch, die Funktionsweise des menschlichen Gehirns nachzuahmen. Obwohl DNNs die strukturellen Merkmale unserer vernetzten Neuronen nachbilden, sind sie nicht in der Lage, die Aspekte abzubilden, die für das semantische Verständnis unseres Gehirns zuständig sind.

Ein Beispiel hierfür: Ein Convolutional Neural Network (CNN) mit der Aufgabe, Objekte in Bildern zu kategorisieren, geht logisch von unten nach oben vor, um Muster zu identifizieren, die auf Fußgänger, Verkehrsschilder und andere Objekte hindeuten. Menschen tun das auch, aber wir gehen auch logisch von oben nach unten vor. Auch wenn Fahrbahnmarkierungen, Stoppschilder und Ähnliches teilweise von Schnee bedeckt sind, können wir sie anhand der sichtbaren Elemente identifizieren. CNNs haben keine derartige Logik, auf die sie zurückgreifen können.

Unser Verständnis der Welt um uns herum ist das Ergebnis lebenslangen Lernens. Dieses Verständnis auf ein DNN zu übertragen, ist schwierig, wenn nicht gar unmöglich. Trotz ihres ausgefeilten Systems fehlt der KI immer noch ein semantisches Verständnis der sie umgebenden Welt.

In einem weiteren Artikel sind wir schon auf das übergroße Vertrauen in die eigenen Fähigkeiten, die Unfähigkeit, neue Inputs zu erkennen, und andere Probleme eingegangen, die die Wahrnehmungen von DNN trüben. Die Forschung des Fraunhofer IKS beschäftigt sich mit diesen Herausforderungen, um die Leistungen von KI zu verbessern. Aber selbst eine unzuverlässige KI-Komponente kann für einen Anwendungsfall nützlich sein, wenn sie in ein System mit Operational Design Domain (ODD) eingebunden wird. Nachstehend werden wir ODDs näher betrachten.

Vertrauen in selbstfahrende Fahrzeuge mit ODD erhöhen

Das Vertrauen in ein automatisiertes Fahrsystem (Automated Driving System, ADS) und seine KI-Komponenten hängt vor allem vom Nachweis der Sicherheit ab. Es wird ein Mechanismus benötigt, der einen ausfallsicheren Betrieb ohne Leistungsverlust garantiert. Eine Möglichkeit besteht darin, den Betriebsumfang des ADS auf einen kleineren Satz an Betriebsbedingungen (Operating Conditions, OC) zu beschränken, die geprüft und als sicher evaluiert wurden. Ingenieure können im Lauf der Zeit OCs zu diesem Satz hinzufügen, in Abhängigkeit von der Reife des ADS und von neuen Tests zur Überprüfung der Sicherheit.

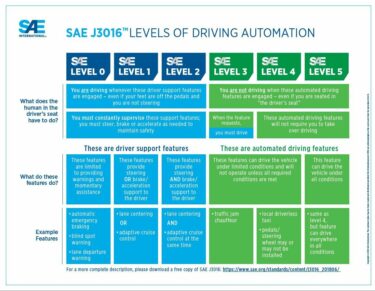

Hier ist es am besten, die vorgesehene Umgebung, Fähigkeiten und Einschränkungen des ADS als Faktoren in die Berechnung einzubeziehen und dann die Bedingungen zu bestimmen, unter denen das System sicher betrieben werden kann. So könnte zum Beispiel der Betrieb eines autonomen Niedergeschwindigkeitstaxis ausschließlich auf ein bestimmtes Gebiet begrenzt werden, das umfangreich getestet wurde; eine kleine, sichere Zone mit genau definierten Strecken und Bedingungen zu spezifischen Tageszeiten. Die Society of Automotive Engineers (SAE) hat inzwischen einen Begriff für die Bedingungen festgelegt, unter denen ein ADS funktionieren soll – die Operational Design Domain (ODD), wie in der SAE-J1306 definiert.

Wenn Ingenieure die Fähigkeiten und Einschränkungen eines ADS bestimmt haben, können sie eine ODD-Spezifikation erstellen, für die sich dieses ADS eignet. Danach überwachen sie die Betriebsumgebung, um OCs zu ermitteln, die von der entsprechenden ODD nicht abgedeckt werden.

© SAE J3016 (https://www.sae.org/news/2019/01/sae-updates-j3016-automated-driving-graphic)

Auf diese Weise werden die Stufen des automatisierten Fahrens definiert, einschließlich der Rolle des Fahrers und der angebotenen Funktionen.

Ein OC-Verstoß führt zu einem ODD-Abbruch. Dann können geeignete Schritte für die entsprechende Automatisierungsstufe, SAE 3 oder 4, ergriffen werden. Bei SAE Stufe 3 ist ein Eingriff des Fahrers möglich: Der Fahrer übernimmt die Kontrolle und steuert die Situation sicher nach eigenem Ermessen. Bei SAE Stufe 4 ist kein Eingriff des Fahrers möglich. Hier könnte als Rückfallebene eine dynamische Fahraufgabe bzw. Dynamic Driving Task (DDT) dienen: Das Fahrzeug verringert die Geschwindigkeit und sucht einen sicheren Ort zum Anhalten. Der Ansatz hier ist die Deeskalation zu einer Situation mit minimalem Risiko (Minimal Risk Condition, MRC) – anders gesagt: das Fahrzeug parken. Daher sind die ODD und ihre Überwachung so essenziell, um Vertrauen in scheinbar unzuverlässige KI-basierte Systeme aufzubauen.

Was ist eine ODD?

SAE J3016 definiert ODD als »Betriebsbedingungen, unter denen ein gegebenes, speziell dafür ausgelegtes Automatisierungssystem oder -element funktioniert, insbesondere umweltbedingte, geografische und tageszeitbedingte Beschränkungen und/oder das erforderliche Vorhandensein oder Fehlen von bestimmten Verkehrs- oder Straßencharakteristika«. Die Norm PAS1883 stellt die Taxonomie zur Definition einer ODD bereit. Sie definiert drei Hauptkategorien für Betriebsbedingungen:

- Umweltbedingungen – Wetter, Beleuchtung, Partikel, Konnektivität usw.

- Infrastruktur – Zone, befahrbarer Bereich, Kreuzungen, spezielle Straßenkonstruktionen usw.

- Dynamische Elemente – Verkehr, Testfahrzeug usw.

OpenODD ist eine Normungsinitiative mit dem Ziel, ein erstes Konzept für ein ODD-Spezifikationsformat zu entwerfen. Fraunhofer IKS ist an diesem OpenODD-Projekt beteiligt.

Der Vorteil einer ODD-Spezifikation für Ingenieure besteht darin, dass sie das ADS in echten Versuchen testen und seine Sicherheit im Rahmen der dedizierten ODD bewerten können. Wenn sie feststellen, dass ein ADS in einer anderen als der vorgesehenen Umgebung arbeitet, können sie Abhilfemaßnahmen ergreifen. Das ist genau der Grund, warum eine ODD-Spezifikation und ihre Überwachung während der Laufzeit die Basis dafür sind, echtes Vertrauen in das System aufzubauen.

Dieses Vorhaben wurde im Rahmen des Projekts Unterstützung des thematischen Aufbaus des Instituts für Kognitive Systeme durch das Bayerische Staatsministerium für Wirtschaft, Landesentwicklung und Energie gefördert.