Nächster Artikel

Unsicherheit in autonomen Systemen, Teil 1

Nicht nur eine Frage der Perzeption

Unsicherheit ist ein häufig betrachtetes Problem von Kognitiven Systemen, gerade bei der Umwelterfassung mit Hilfe von Machine Learning. Aber nicht nur Sensorik gilt als eine Quelle für Unsicherheit. Viele Entscheidungen im Lebenszyklus eines hochkomplexen Systems sind anfällig für unsicheres Wissen. Teil 1 unserer Reihe zum Thema Unsicherheit befasst sich mit dem aktuellen Stand der Technik.

© iStock/Wicki58

Wenn ein Mensch oder ein autonomes System Entscheidungen trifft, basieren diese auf dem Wissen, das ihm zur Verfügung steht. Sind alle Informationen vorhanden, ist es leicht, optimal zu entscheiden. In fast allen Fällen ist Wissen jedoch unvollständig oder Fakten sind nur ungefähr bekannt. In solchen Situationen spricht man von unsicherem Wissen. Unsicherheit ist definiert als

»Any deviation from the unachievable ideal of completely deterministic knowledge of the relevant system.[1]«

Diese Definition stammt aus der Forschungsgemeinschaft für modellbasierte Unterstützung von Entscheidungen, mit deren Hilfe zum Beispiel Politikerinnen und Politiker Gesetze mit weitreichenden Folgen bewerten. Das Thema Unsicherheit ist aber ebenso wichtig für autonome Systeme: Insbesondere sicherheitskritische Systeme müssen Entscheidungen treffen, die ihre Umwelt stark beeinflussen und potenziell sogar Menschenleben gefährden können.

Unsicherheit identifizieren

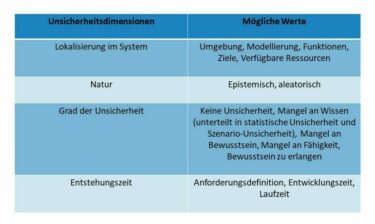

Es ist daher sehr wichtig, bei der Entwicklung eines autonomen Systems alle Arten von Unsicherheit zu identifizieren, die die Entscheidungsfähigkeit des Systems beeinträchtigen könnten. Zu diesem Zweck haben verschiedene Forscherinnen und Forscher eine Taxonomie entwickelt, die Unsicherheit anhand von mehreren Dimensionen in Klassen unterteilt. Dieses Klassifizierungssystem ist in Tabelle 1 zusammengefasst. In der Literatur sind vier Dimensionen geläufig, die wir im Folgenden erklären.

© Fraunhofer IKS

Tabelle 1: Klassifizierungssystem für Unsicherheit

Lokalisierung im System

Diese Dimension beschreibt, wo die Unsicherheit im System auftritt. Hier sind fünf Orte vorstellbar:

- Besteht unvollständiges Wissen über die Eigenschaften der Umgebung, in der das System eingesetzt werden soll, spricht man von Umgebungsunsicherheit. So stellt zum Beispiel die Fülle an schwer zu erfassenden Grenzsituationen wie regional unterschiedliche Straßenmarkierungen eine Hürde für sicheres autonomes Fahren dar.

- Häufig treffen autonome Systeme Entscheidungen auf Basis von Modellen, da die reale Situation nicht bis ins kleinste Detail abgebildet werden kann. Die Wahl der Modellierung birgt aber eine große Modellunsicherheit, die beispielsweise durch ein zu hohes Level an Abstraktion entsteht.

- Zusätzlich zur Umgebung und Modellierung sind auch die Funktionen des autonomen Systems selbst von Funktionsunsicherheit betroffen. Neben der bereits angesprochenen Perzeption können auch Aktionen, die das System ausführt, schwer vorhersagbare Folgen haben oder mit einer bestimmten Wahrscheinlichkeit fehlschlagen.

- Ebenfalls wichtig als Entscheidungsgrundlage sind die Ziele, die das autonome System verfolgen soll. Hier spielt Zielunsicherheit eine Rolle und beeinträchtigt, dass sich das System so verhält wie erwartet.

- Zu guter Letzt muss das System für die Ausführung einer Entscheidung über gewisse Ressourcen verfügen. Ressourcenunsicherheit beeinflusst die Entscheidungsfähigkeit also ebenfalls negativ, wenn einzelne Ressourcen, zum Beispiel durch zufällige Hardwarefehler, nicht verfügbar sind.

Natur der Unsicherheit

Grundsätzlich unterscheidet die Literatur zwei Arten von Unsicherheit, aleatorische und epistemische. Aleatorische Unsicherheit (von lateinisch alea – der Würfel) entsteht durch unvorhersagbare, inhärent zufällige Prozesse in der Natur. Darunter fällt auch Unsicherheit, die durch menschliches Verhalten entsteht. Die Ursache für epistemische Unsicherheit ist im Gegensatz dazu fehlendes Wissen. Diese Art von Unsicherheit könnte also durch zusätzlichen Aufwand beseitigt werden.

Grad der Unsicherheit

Nicht alle Informationen, über die ein autonomes System verfügt, sind gleich zu behandeln. Insbesondere beschreibt Unsicherheit keine Einteilung in schwarz oder weiß, bekannt oder unsicher. Stattdessen kann man den Grad der Unsicherheit auf einer Skala einordnen: Keine Unsicherheit; Mangel an Wissen, aber Bewusstsein über diesen Mangel; Mangel an Bewusstsein; bis hin zu Mangel an Fähigkeit, Bewusstsein zu erlangen. (s. Tabelle). Einige Autoren unterscheiden für Mangel an Wissen zwei Möglichkeiten, diesen Mangel darzustellen. Statistische Unsicherheit kann mithilfe von statistischen Methoden wie Wahrscheinlichkeitstheorie ausgedrückt werden. Szenario-Unsicherheit wiederum lässt sich nur mit einer Auflistung möglicher Alternativen beschreiben.

Entstehungszeit

Abschließend ist Unsicherheit kein reines Laufzeitphänomen. Sie kann zu jedem Zeitpunkt des Softwarelebenszyklus entstehen und wird sich auf die folgenden Phasen auswirken, wenn sie nicht beseitigt wird. So führt ein unzureichendes Verständnis des Systems und dessen Einsatzumgebung während der Anforderungsdefinition zu falsch definierten Anforderungen. Durch Programmierfehler während der Entwicklungszeit sinkt die Gewissheit, dass das System korrekt funktioniert. Beides wirkt sich dann auf das Entscheidungsvermögen des autonomen Systems zur Laufzeit aus.

Dieses Klassifizierungssystem gibt einen detaillierten Überblick über eine Vielzahl von Unsicherheiten, die autonome Systeme beeinflussen können. Die Arbeit des Fraunhofer-Instituts für Kognitive Systeme IKS mit Industriepartnern hat gezeigt, dass es auch im praktischen Einsatz relevant und hilfreich ist. So konnten unsere Forscherinnen und Forscher mithilfe des Systems zum Beispiel analysieren, welche Tests notwendig sind, um die Resilienz eines Logistik-Roboters zu bestätigen. Ein umfassendes Verständnis von Unsicherheit bildet also die Grundlage, um autonome Systeme gegen Fehlverhalten abzusichern. Unsicherheitsmanagement ist daher ein zentrales Forschungsfeld des- Fraunhofer IKS.

[1] Übersetzung des Autors: Jegliche Abweichung vom unerreichbaren Ideal von vollständigem, deterministischem Wissen über das relevante System, W.E. Walker et al. “Defining Uncertainty: A Conceptual Basis for Uncertainty Management in Model-Based Decision Support”, 2003.

Im zweiten Teil des Blogbeitrags stehen die Quellen der Unsicherheit im Mittelpunkt.