Nächster Artikel

Unsicherheitsbestimmung, Teil 1

Uncertainties, auf die man sich verlassen kann

Komplexe Verfahren des Machine Learning (ML) stellen Forscherinnen und Forscher vor ein Problem: Das Ausschließen von Fehlern vor der Inbetriebnahme autonomer Systeme sowie die zuverlässige Erkennung von Fehlern zur Laufzeit sind aufwendig und anspruchsvoll. Dies schränkt aktuell den Einsatz von Machine Learning in sicherheitskritischen Systemen deutlich ein und erfordert neue Ansätze, um zukünftig auch in diesen Bereichen von den Vorteilen, die ML bietet, profitieren zu können.

© iStock.com/Oleh_Slobodeniuk

Um KünstIiche Intelligenz (KI) in sicherheitskritischen Anwendungen wie selbstfahrenden Autos oder bei der automatisierten Diagnose von Krankheitsbildern in der Medizin einsetzen zu können, muss sie abgesichert sein. Für die Vorhersagen dieser Systeme müssen deswegen zuverlässige Unsicherheitswerte (uncertainty values) bestimmt werden. Ein Beispiel: Ein autonomes Fahrzeug entdeckt per Sensor ein Objekt auf der Straße und muss in Sekundenbruchteilen zuordnen, ob es sich dabei um einen Menschen handelt oder um etwas anderes. Die Unsicherheitswerte geben Auskunft darüber, wie zuverlässig die aktuellen Vorhersagen der KI in diesem Fall sind. Diese Werte dienen weiteren Komponenten des gesamten Safety-Systems als Einflussgröße für die Bewertung des aktuellen Zustands in Bezug auf die Sicherheit.

© Fraunhofer IKS

KI-basierte 2D- Objekterkennung mit Unsicherheitswerten

Die Bestimmung solcher Unsicherheitswerte stellt eine herausfordernde Aufgabe dar. Man kann sich viele ML-Modelle, insbesondere neuronale Netze, als sehr komplex verschachtelte Funktionen vorstellen, die zum Beispiel im Falle der Klassifizierung ein Bild einer Kategorie (Label) zuordnen. Beim Trainieren solcher Modelle werden die Parameter so verändert, dass sich die Konfidenzwerte – quasi das Maß für die Sicherheit einer Aussage – der jeweils richtigen Klassen erhöhen. Doch obwohl diese Konfidenzwerte oft die Eigenschaft haben, zwischen 0 und 1 zu liegen und in Summe 1 ergeben, können diese nicht einfach als Wahrscheinlichkeit interpretiert werden.

So neigen vor allem die in ihrer Performance so mächtigen neuronalen Netze dazu, nicht selten auch bei falschen Vorhersagen eine sehr hohe Konfidenz auszugeben und schlecht kalibriert zu sein. Von einem schlecht kalibrierten Modell spricht man, wenn der Durchschnitt der Konfidenzwerte nicht mit der durchschnittlichen Richtigkeit der Vorhersagen übereinstimmt. Das heißt: Wenn ein Modell im Durchschnitt 70 Prozent konfident ist, sollte es auch in 70 Prozent aller Aussagen wirklich richtig liegen. Allerdings hatten einige Veränderungen im Design und Training neuronaler Netze, die die allgemeine Performance dieser Modelle deutlich verbessert haben, auch den ungünstigen Nebeneffekt, die Kalibrierung zu verschlechtern in Richtung von zu hohen Konfidenzwerten (Modelle sind »overconfident«).

Machine Learning lässt sich austricksen

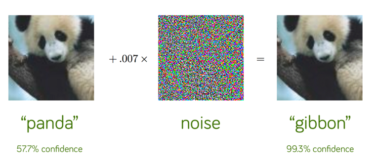

Zudem ist mittlerweile weithin bekannt, dass es möglich ist, durch gezielte minimale Veränderungen des Inputs viele ML-Modelle auszutricksen. Mithilfe dieser sogenannten »Adversarial Attacks« kann man zum Beispiel systematisch Modelle dazu bringen, eine gewünschte Klasse mit sehr hoher Konfidenz vorherzusagen, auch wenn diese der wahren Klasse sehr unähnlich ist.

Eine weitere Ursache der häufig unzuverlässigen Konfidenzwerte ist, dass Modelle auf Datensätzen trainiert werden, welche keine vollständige Beschreibung der Realität mit allen möglichen Zuständen darstellen. So ist es zum Beispiel nicht verwunderlich, wenn ein Modell, welches nur mit Bildern von Hunden und Hauskatzen trainiert wurde, einen Jaguar mit sehr hoher Konfidenz als Hauskatze klassifiziert. Das liegt daran, dass das Modell das Konzept eines Jaguars nicht kennt und der Jaguar einer Hauskatze deutlich ähnlicher sieht als einem Hund.

© Goodfellow, I. J., Shlens, J., & Szegedy, C. (2014).

KI: Minimales Bildrauschen macht aus einem Panda einen Affen

Fraunhofer IKS macht KI selbstkritischer

Darüber hinaus kann es ein Problem sein, dass viele etablierte Verfahren des Machine Learning bestimmte einzelne Werte als Parameter annehmen, anstatt die Verteilung dieser Werte zugrunde zu legen. Das ist deswegen nicht optimal, da kein Grund zur Annahme besteht, dass ein einzelnes, starres Modell die auftretenden Muster und Zusammenhänge am besten beschreibt. Dies erhöht die Gefahr, dass sich die Modelle in ungünstigen Fällen irreleiten lassen.

Für den Fall des autonomen Fahrens können die oben beschriebenen Probleme lebensbedrohliche Folgen haben. So ist es gut möglich, dass eine verkleidete Person oder eine Person in ungewöhnlicher Pose nicht als Mensch identifiziert wird und es dadurch zu einem Unfall kommt.

Um solchen Fehlern vorzubeugen, entwickeln wir am Fraunhofer IKS Methoden, die es ermöglichen, Entscheidungsfälle, die sich stark von den gelernten Konzepten aus dem Trainingsdatensatz unterscheiden, mit höheren Unsicherheitswerten zu belegen. Damit kann das Modell besser quantifizieren, wenn es sich in der Vorhersage nicht sicher ist.

Mit seiner Expertise in diesem Bereich ist das Fraunhofer IKS Teil

des ADA Lovelace Centers for Analytics, Data and Applications. Dabei

handelt es sich um eine Kooperationsplattform, an der die

Fraunhofer-Institute IIS, IISB und das IKS sowie die

Friedrich-Alexander-Universität Erlangen-Nürnberg und die

Ludwig-Maximilians-Universität München beteiligt sind.

Conference Paper, 2019

Managing Uncertainty of AI-based Perception for Autonomous Systems

Publica.fraunhofer.deInformationen über die Agebote des Fraunhofer IKS finden Sie auf unserer Website zum Thema Zuverlässige Künstliche Intelligenz.