Nächster Artikel

Verifizierung von medizinischen KI-Systemen

Was die Vorschriften für medizinische Diagnosealgorithmen voraussetzen

Regelungen und Standards für vertrauenswürdige Künstliche Intelligenz existieren bereits, und Hochrisiko-KI-Systeme in der Medizin stehen bald zur Prüfung an. Doch wie genau lassen sich diese Hochrisiko-Regeln in technische Maßnahmen zur Validierung von tatsächlichem Code und Algorithmen umsetzen? Das AI-Verifikationsframework des Fraunhofer IKS setzt hier an und bietet eine Lösung.

© iStock/Claudio Ventrella

Stellen Sie sich vor, Sie sind ein versierter medizinischer Daten-wissenschaftler und haben ein medizinisches Diagnosesystem entwickelt. Es klassifiziert Krebszelltypen in medizinischen Bildern mit hoher Präzision. Wie üblich haben Sie es mit Testdaten getestet und seine Fehlermodi analysiert. Jetzt ist es an der Zeit, es als Software-Tool zu verpacken und an die Kunden auszuliefern. Doch nun stellt sich die große Frage: Wurden alle Grundlagen geprüft und abgedeckt, bevor die Anwendung in der realen Welt eingesetzt wird, wo Menschenleben auf dem Spiel stehen?

Regulierungen und Standards sorgen für sichere und vertrauenswürdige KI

Sicherheit und Vertrauenswürdigkeit von Künstlicher Intelligenz (KI) waren schon immer von Relevanz und sind es nun mit der Vorstellung des EU-AI-Acts [1] mehr denn je. Denn diese bahnbrechende Veröffentlichung stellt eine solide Grundlage dafür da, dass jeder Aspekt der KI-Entwicklung akribisch behandelt wird.

Betrachten wir das Beispiel des medizinischen KI-Systems und schauen uns den EU-AI-Act, Artikel 9 (Risikomanagementsystem) Absatz 2, an. Es schreibt die Schaffung eines Risikomanagementsystems für Hochrisiko-KI-Systeme vor und umfasst die folgenden Schritte (mit Paraphrasierung zitiert):

- Identifikation und Analyse der bekannten und absehbaren Risiken;

- Berücksichtigung der Risiken während der Nutzung gemäß dem beabsichtigten Zweck und unter Bedingungen einer vernünftigerweise absehbaren Fehlanwendung;

- Bewertung der Risiken auf Grundlage von Daten des Überwachungssystems nach Markt;

- Annahme geeigneter Risikomanagementmaßnahmen.

Das ist ausgezeichnet! Sie haben jetzt eine Referenzrichtlinie, um eine vertrauenswürdige KI-Entwicklung

sicherzustellen, die für zukünftige Zertifizierungen geeignet ist.

Anforderungen oder Interpretation

von Anforderungen?

Jetzt müssen Sie jede Anforderung im Kontext Ihres Anwendungsfalls – des medizinischen Diagnosesystems – interpretieren. Darüber hinaus müssen die von Ihnen bereitgestellten Argumente transparent, kohärent und solide genug sein, um Ihre Kunden zu überzeugen und Zertifizierungsstellen zufriedenzustellen.

Betrachten wir Schritt 2 für den Anwendungsfall des medizinischen Bildklassifikators: Was ist der genaue beabsichtigte Zweck? Wie werden Ärzte die KI nutzen? Was sind potenzielle Missbrauchsszenarien? Für jeden Fall von beabsichtigter Nutzung und potenziellem Missbrauch müssen alle Risiken erkundet und dokumentiert werden, die auftreten können. Dies erfordert viel Zeit, Aufwand und multidisziplinäre Zusammenarbeit.

Und das war gerade mal der Anfang. Angenommen, Sie wenden dieses Maß an Überprüfung auf alle Anforderungen des EU-AI-Acts für ein größeres Projekt an, das mehrere Unternehmen und komplexere KI umfasst. Denken Sie nun an die Hindernisse des Managements: Wer ist für die Erfüllung welcher Anforderung verantwortlich? Wie können wir einen konkreten Plan für eine sichere und vertrauenswürdige KI-Entwicklung mit vielen Stakeholdern erstellen?

Hier kommt die Lösung des Fraunhofer IKS ins Spiel: der KI-Verifikationsbaum

Stellen Sie sich eine Baumstruktur vor, die aus Sicherheitsaussagen für KI-Systeme besteht. An der Wurzel haben wir die übergeordneten Artikel des EU-AI-Acts. Ein Hauptast besteht aus der folgenden Aussage: "KI-System erfüllt Artikel 9.2". Er verzweigt sich dann in vier Elemente a, b, c, d (in Artikel 9.2). Jeder Unterast unterteilt sich weiter in Unteräste und so weiter, bis wir zu den "Blättern" des Baumes gelangen, die praktische, technische Tests und Codeprüfungen

darstellen. Der Verifikationsbaum deckt mehrere KI- und Anwendungskategorien ab und jede Kategorie stellt einen neuen Ast im Baum dar.

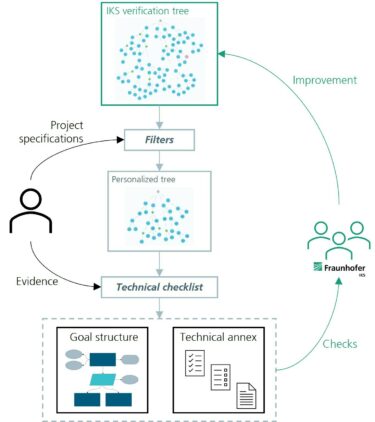

Wir haben dieses Projekt 2023 begonnen und unseren Ansatz "KI-Verifikationsbaum" bezeichnet. Der Prozess der Nutzung des Verifikationsbaumes ist in Abbildung 1 dargestellt. So funktioniert er:

© Fraunhofer IKS

Der Verifikationsbaum erleichtert den komplexen Prozess der KI-Verifizierung. Benutzer beschreiben ihr Projekt, erhalten eine maßgeschneiderte Checkliste und liefern technische Nachweise zur Untermauerung ihrer Aussagen.

Ein Benutzer beginnt damit, die Projektspezifikationen anzugeben. Diese Informationen dienen zur Filterung des Baums, indem sie nur die relevanten Äste für das Projekt einbeziehen. Auf Grundlage dessen wird eine Checkliste erstellt, die alle notwendigen Nachweise zur Untermauerung der Aussagen im Baum auflistet. Der Benutzer liefert technische Nachweise, um jedes Element zu erfüllen. Sobald der Prozess abgeschlossen ist, werden automatisch Dokumente generiert, die gemäß der akzeptierten Sicherheitssprache verfasst sind. Sie werden nach dem Verantwortlichen für jede Behauptung sowie nach dem Stadium des KI-Lebenszyklus kategorisiert, in dem die Behauptung behandelt wird.

Treffen Sie uns auf der DMEA in Berlin!

Haben Sie Fragen zu unserer Forschung und unseren Dienstleistungen? Wir würden uns freuen, Sie an unserem Stand auf der DMEA begrüßen zu dürfen.

Das Fraunhofer-Institut für Kognitive Systeme IKS konzentriert sich auf den Einsatz vertrauenswürdiger Künstlicher Intelligenz (KI) im Gesundheitswesen unter dem Motto: Trustworthy Digital Health. Ein Anwendungsfall ist die Nutzung erklärbarer KI (explainable AI) in der medizinischen Diagnostik, etwa bei der Einstufung von Wirbelfrakturen und der Blutzellen-Klassifikation. Ein weiteres Beispiel: dateneffiziente KI, die Ärzte bei der Auswertung medizinischer Bilder zur Krebsfrüherkennung unterstützt. Und schließlich zeigt das Fraunhofer IKS, wie eine Quantencomputing-gestützte KI medizinische Diagnosen verbessern kann.

Besuchen Sie uns auf der DMEA 2024 auf dem Berliner Messegelände, am Stand D-108 der Fraunhofer-Gesellschaft in Halle 2.2.

Wir freuen uns darauf, Sie kennenzulernen!

Die Entwicklung eines vereinheitlichenden Verifizierungsprozesses für vielfältige Szenarien ist eine Herausforderung, die wir mit einem realisierbaren Entwicklungsplan angehen, der auf unserer Expertise im Bereich "safeAI" basiert. Diese haben wir erfolgreich in Projekten der Automobil- und Schienenverkehrsindustrien unter Beweis gestellt. Anhand des Feedbacks aus diesen Projekten verbessern und überarbeiten wir den Quellverifizierungsbaum entsprechend. Dieser Feedbackprozess schafft eine dynamische Wissensbasis, die mit jeder Verwendung besser wird.

Der Verifizierungsbaum ist nur ein Teil eines größeren Projekts - des Verifizierungs-Frameworks, einem laufenden Projekt am Fraunhofer IKS. Dieser Rahmen umfasst verschiedene Methoden wie die Quantifizierung der Unsicherheit bei der Sicherheitsgewährleistung von KI-Systemen, automatisierte Tests für Deep-Learning-Modelle [2] und Simulationswerkzeuge für kausale Inferenzmethoden [3]. Der Verifizierungsbaum wird kontinuierlich erweitert und verfeinert, wobei der Schwerpunkt auf Anwendungen im Gesundheitsbereich liegt.

[1] Erreichbar unter https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=celex%3A52021PC0206

[2] Robuscope: siehe https://www.iks.fraunhofer.de/en/services/testing-ai-models-online.html

[3] PARCS: siehe https://github.com/FraunhoferIKS/parcs

This work was funded by the Bavarian Ministry for Economic Affairs, Regional Development and Energy as part of a project to support the thematic development of the Institute for Cognitive Systems.